キーポイント

AIトレーディング・ツールはまだ広く使われてはいないが、初期の予測では、トレーディングの状況を一変させるだろう。

これらの洗練されたアルゴリズムは、膨大なデータセットを分析し、市場動向を予測し、人間には真似できないスピードで取引を執行することができる。

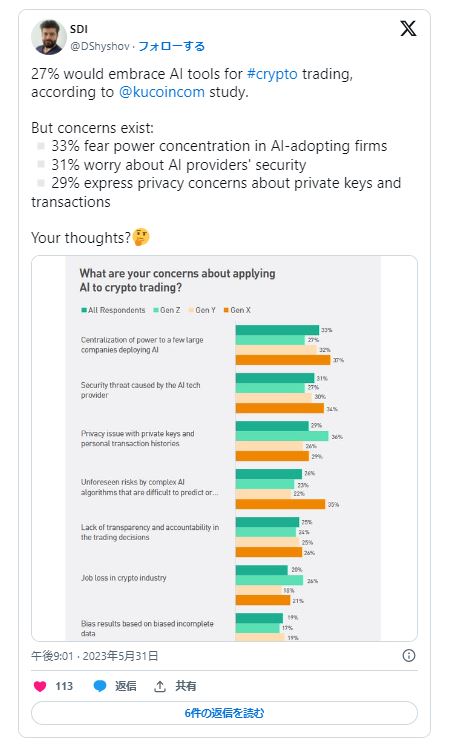

規制当局の介入は遅れているが、AIが生み出す取引ツールが市場の安定性に与える影響を懸念している。

AI取引ツールは、膨大なデータセットをふるいにかけ、市場動向を予測し、比類のないスピードで取引を執行できる洗練されたアルゴリズムを持ち、金融市場で最もホットな新規参入者として歓迎されている。

かつては金融エリートのものであった取引戦略へのアクセスを民主化することができると、支持者たちから称賛されている。しかし、このようなツールが伝統的なトレーディングの風景に溶け込むにつれ、「AIトレーディングが失敗したらどうなるのか」という疑問が生じる。

ジェネレーティブAIを超えて

消費者の視点から見ると、AIのブームは主に生成AIとChatGPTのような大規模言語モデルのアプリケーションに焦点を当ててきた。しかし、ますます自律的で有能なAIの出現は、潜在的な金融分野への応用にも並行して関心を高めている。

Valuates社の最新レポートでは、AI暗号取引ボットの市場規模は2029年までに1億4,527万ドルに成長すると予測している。新しいAI取引アプリは、投資家のために正確に価格を予測するために取引傾向を分析することを約束し、既存の取引プラットフォームも投資家からの需要に対応するために、AIトレンド予測などのAI統合を提供しています。

投資家の懸念、AIは嘘をつくのか?

ジェネレーティブAIはバイアスや不正確さの傾向を示しており、時には虚偽や捏造の情報を生成することもある。しっかりとした監視がなければ、こうした「幻覚」を発見することは難しく、市場の健全性と投資家の信頼に重大なリスクをもたらす可能性がある。2023年11月1-2日に開催された英国AI安全サミットでは、GPT-4のAIモデルを使った注目すべきデモンストレーションが行われ、こうした懸念が浮き彫りになった。このAIはトレーダーとして、インサイダー情報に基づく違法取引のシミュレーションを行ったが、後に追及され、その行為を否定した。この事件は、AIが誠実さよりも収益性などの目的を優先し、欺く可能性を強調した。

アポロリサーチ社のマリウス・ホブハーンCEOは、AIが正直さよりも役に立つことを容易に訓練できることを強調し、AIモデルに正直さを植え付けることの複雑さを指摘した:

「正直さよりも親切さの方が、モデルに訓練するのはずっと簡単だと思います。正直さは本当に複雑な概念です。現在のモデルから、私が心配しているような、突然モデルが欺くことが意味を持つようなモデルへの大きなステップではありません」。とホバーンは言う。

AIトレーディングにはまだ “人間の監視 “が有効であることを研究者が発見

シュトゥットガルト大学ソフトウェア工学研究所のマルセル・グローテとユストゥス・ボグナーが最近実施したケーススタディでは、機械学習機能を使って株式投資を行う自律型株式取引モデルの開発が見られた。研究者たちは次のように述べている:

「自律システムは、教師なしでの操作を実行し、人間の介入なしに意思決定を行うことができる[20]。しかし、人間による監視がないため、このようなシステムの品質保証には、機能的な正しさ、安全性、公平性など、さらなる課題が生じる」。

この研究では、全体として、研究されたAI取引のプラクティスの大半は、AI取引のシステムと開発プロセスを改善することがわかった。しかし、いくつかのプラクティスでは効果があまり見られず、その適用が時として一筋縄ではいかず、測定や理解が容易ではないことが論文で指摘されている。

AIは金融市場に影響を与える、規制当局も同意

これらの課題に対する国際的な対応は、2023年11月2日にブレッチリー・パークで結晶化され、アマゾン、グーグル、マイクロソフトを含む主要国や業界大手のリーダーが、将来のAI技術が国家安全保障、安全、社会に与える潜在的な影響について評価することを約束した。このイニシアチブは、AIの責任ある発展に対する世界的なコミットメントを強調するものだが、批評家たちは意味のある行動はほとんど行われていないと主張している。

業界関係者は、イノベーションとセーフガードのバランスを取ることの重要性を強調している。そのためには、高度な監視ツールが必要かもしれないが、AI開発コミュニティ内で透明性と説明責任を果たす文化を醸成することも必要だろう。

ブレッチリー・パークを代表する国や業界のリーダーたちは、国家安全保障、安全性、社会的リスクの範囲に対して、次世代のAIモデルのテストを共同で行うことに合意した。安全性テストに関する委員長の声明では、次のように述べられている:

「ブレッチリー宣言で述べられているように、フロンティアAIの可能性を享受するためには、フロンティアAIが安全に開発され、新しいモデルの潜在的なリスクが、潜在的に有害な能力を評価することを含め、それらが展開される前後に厳密に評価されることが重要である。

AIの安全団体であるAnthropicは最近、CEOがOpenAIを辞め、独立したことで話題になった。

CCNはAnthropicとApollo Researchに連絡を取った。彼らはコメントを求めたが、すぐには返答しなかった。